Khi huấn luyện mạng nơ-ron sâu, mô hình thường gặp khó khăn vì dữ liệu đầu vào của mỗi lớp liên tục thay đổi, khiến việc tối ưu trở nên chậm và kém hiệu quả. Đó là lý do vì sao Batch Normalization ra đời như một giải pháp quan trọng giúp cải thiện tốc độ huấn luyện và độ chính xác của mô hình. Vậy Batch Normalization là gì và vì sao nó lại được sử dụng phổ biến trong các mô hình học sâu hiện nay? Hãy cùng VNPT AI tìm hiểu chi tiết trong bài viết dưới đây.

Batch Normalization là gì?

Batch Normalization là một kỹ thuật trong học sâu (deep learning) giúp giúp tăng tốc độ huấn luyện và cải thiện độ ổn định của mô hình. Khi huấn luyện các mạng nơ-ron có nhiều lớp, dữ liệu đầu vào của mỗi lớp có thể thay đổi liên tục khiến mô hình khó học. Batch Normalization giúp điều chỉnh dữ liệu này về một dạng chuẩn hơn, nhờ đó mô hình dễ học hơn, ít lỗi hơn và đạt kết quả tốt hơn.

Batch Normalization hoạt động như thế nào?

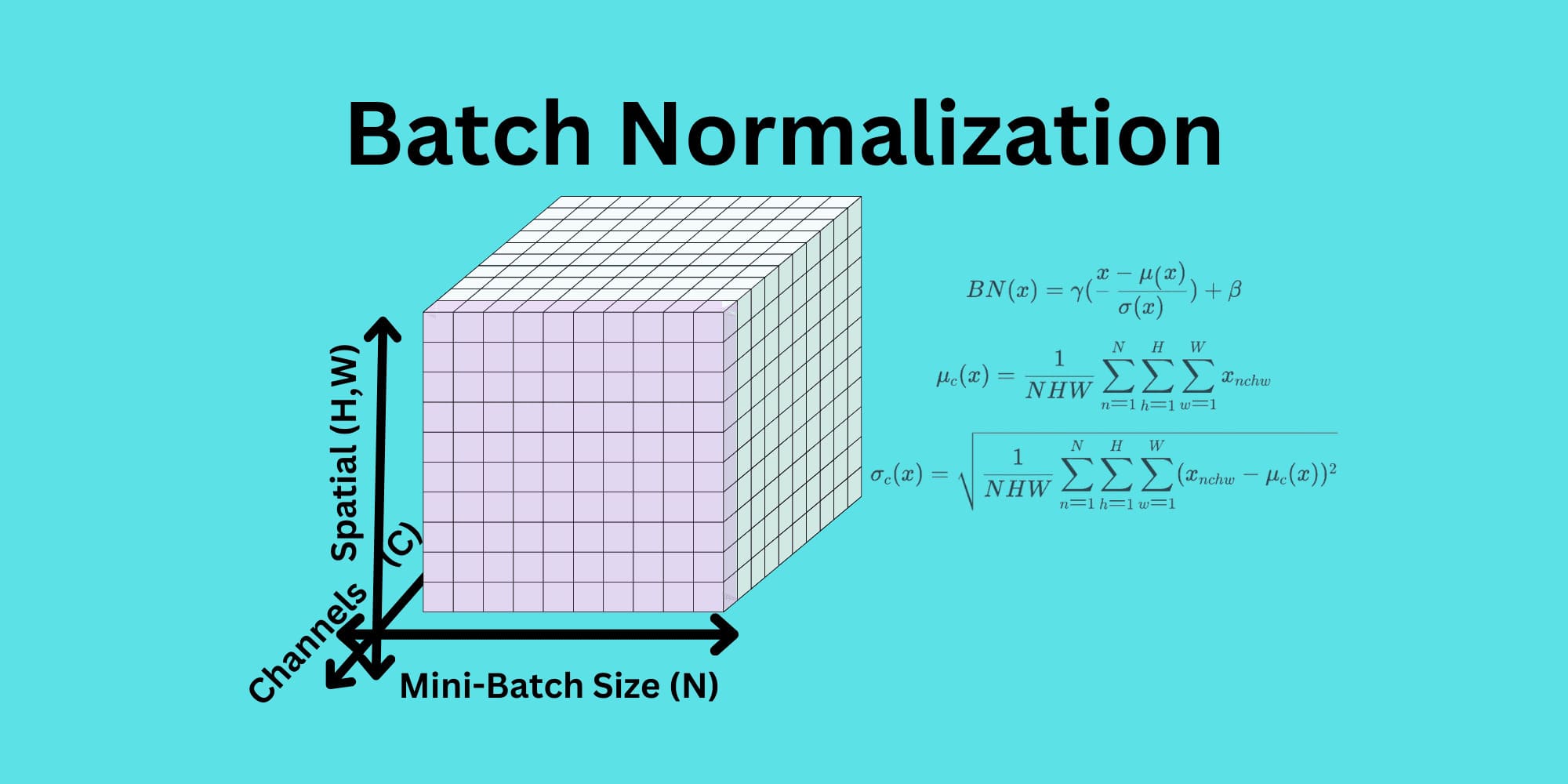

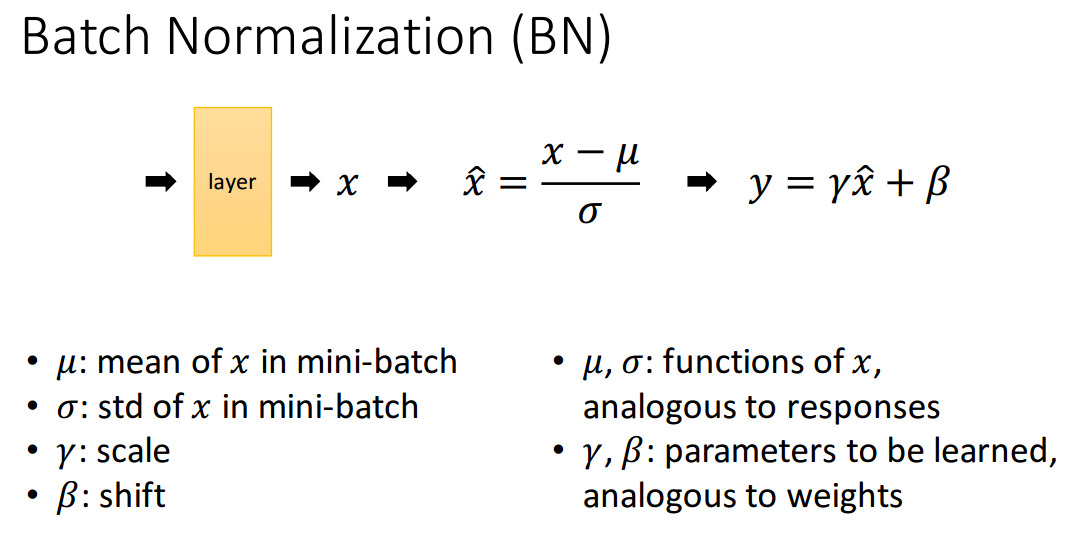

Bằng cách chuẩn hóa đầu ra của từng lớp dữ liệu, Batch Normalization giúp mạng nơ-ron học ổn định và nhanh hơn. Cụ thể, hệ thống này hoạt động qua 2 bước chính:

- Chuẩn hóa: Đầu ra của lớp được chuẩn hóa bằng cách trừ đi giá trị trung bình (mean) và chia cho độ lệch chuẩn (standard deviation) của batch đó, từ đó giúp dữ liệu hoạt động ổn định hơn.

- Điều chỉnh: Sau khi chuẩn hóa, dữ liệu được nhân với một tham số gamma (γ) và cộng với một tham số beta (β). Đây là hai tham số mà mô hình sẽ học để đảm bảo vẫn giữ được độ linh hoạt trong biểu diễn.

Nhờ quá trình chuẩn hóa và điều chỉnh, Batch Normalization giúp mô hình dễ huấn luyện hơn do giảm được hiện tượng lệch dữ liệu trong quá trình lan truyền. Đồng thời, công nghệ này cho phép sử dụng learning rate cao hơn mà vẫn đảm bảo độ ổn định, từ đó rút ngắn thời gian huấn luyện. Bên cạnh đó, mô hình cũng trở nên ít phụ thuộc hơn vào việc khởi tạo trọng số ban đầu, giúp quá trình huấn luyện trở nên linh hoạt và hiệu quả.

Các phương pháp của Batch Normalization

Một số phương pháp Batch Normalization được ứng dụng phổ biến nhất bao gồm:

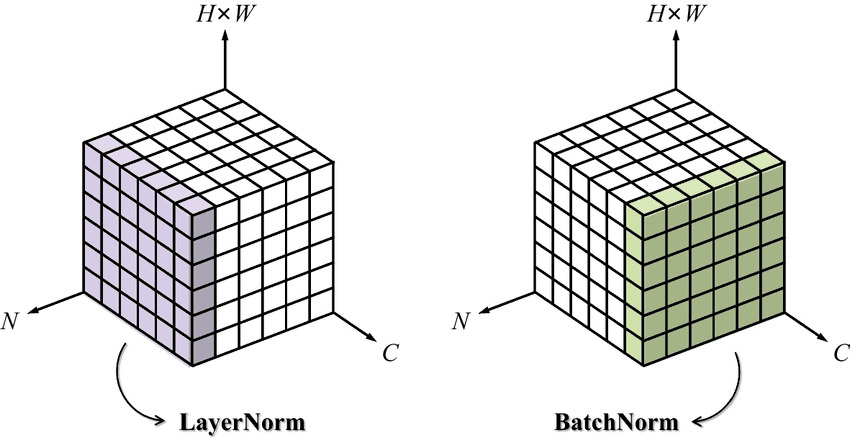

Layer Normalization

Layer Normalization là một kỹ thuật giúp tăng tốc độ huấn luyện và cải thiện độ ổn định cho các mô hình mạng nơ-ron. Không giống như Batch Normalization, vốn chuẩn hóa các đặc trưng đầu vào dựa trên toàn bộ các mẫu trong một mini-batch, Layer Normalization lại hoạt động trên từng mẫu riêng lẻ. Cụ thể, thay vì tính toán trung bình và độ lệch chuẩn theo chiều của batch (nghĩa là trên nhiều ví dụ), phương pháp này tính toán các thống kê đó dựa trên toàn bộ các đặc trưng trong một mẫu duy nhất.

Một trong những ưu điểm lớn nhất của Layer Normalization là nó không phụ thuộc vào kích thước của batch, vì vậy nó đặc biệt hiệu quả trong các trường hợp batch size nhỏ hoặc thay đổi liên tục. Phương pháp này cũng rất phù hợp với mạng nơ-ron hồi tiếp (RNN), vốn xử lý dữ liệu theo chuỗi và không tương thích tốt với batch normalization do đặc thù xử lý tuần tự và sự phụ thuộc giữa các bước thời gian.

Group Normalization

Group Normalization là một kỹ thuật chuẩn hóa trong mạng nơ-ron và được xem như một giải pháp thay thế cho Batch Normalization. Khác với Batch Normalization vốn phụ thuộc vào kích thước batch, Group Normalization hoạt động độc lập với batch size, nên phù hợp với các trường hợp như xử lý ảnh độ phân giải cao hoặc trong môi trường giới hạn bộ nhớ.

Cách thức hoạt động của Group Normalization là chia các kênh đầu ra của một lớp thành nhiều nhóm nhỏ, sau đó thực hiện tính toán giá trị trung bình và phương sai để chuẩn hóa riêng trong từng nhóm. Nhờ tính linh hoạt này, Group Normalization mang lại độ ổn định cao hơn trong huấn luyện, đồng thời cải thiện hiệu suất mô hình trong nhiều tình huống mà các phương pháp chuẩn hóa khác gặp hạn chế.

Instance normalization

Instance Normalization là một phương pháp chuẩn hóa được thực hiện riêng biệt trên từng kênh của từng ảnh đầu vào, thay vì áp dụng cho cả lô dữ liệu như trong Batch Normalization. Cách tiếp cận này đặc biệt phù hợp với các bài toán như chuyển phong cách hình ảnh hay tạo sinh hình ảnh, nơi mà yêu cầu chính là giữ nguyên phong cách của ảnh nhưng vẫn làm nổi bật được nội dung mới.

So với Layer Normalization, Instance Normalization chỉ chuẩn hóa theo từng kênh, từ đó giúp kiểm soát chi tiết hơn cách thông tin được điều chỉnh trong từng ảnh. Với những ưu điểm này, Instance Normalization trở thành lựa chọn lý tưởng trong các ứng dụng liên quan đến xử lý ảnh sáng tạo và nghệ thuật.

Lợi ích của Batch Normalization

Bên cạnh những lợi ích nổi bật như cải thiện hiệu quả và độ ổn định trong quá trình huấn luyện các mô hình học sâu, Batch Normalization còn gây ấn tượng nhờ những ưu điểm:

- Ổn định quá trình huấn luyện: Batch Normalization làm giảm sự thay đổi quá mức giữa các lớp trong mạng nơ-ron khi huấn luyện, từ đó giúp mô hình học ổn định và hiệu quả hơn.

- Tăng tốc độ học của mô hình: Nhờ vào việc chuẩn hóa, mô hình có thể học nhanh hơn và rút ngắn thời gian huấn luyện.

- Giảm phụ thuộc vào khởi tạo trọng số ban đầu: Với Batch Normalization, mô hình không còn quá nhạy cảm với việc chọn trọng số ban đầu. Nói cách khác, bạn không cần mất nhiều công sức để khởi tạo “chuẩn chỉnh” ngay từ đầu, vì hệ thống sẽ giúp cân bằng lại các giá trị trong quá trình huấn luyện, giúp mô hình học dễ dàng và ổn định hơn.

- Cải thiện khả năng khái quát hóa: Batch Normalization chuẩn hóa các giá trị đầu ra của từng lớp trong mạng, do đó tránh tình trạng "học vẹt" quá mức trên dữ liệu huấn luyện. Nhờ đó, khi gặp dữ liệu mới, mô hình vẫn giữ được độ chính xác cao.

Thách thức và hạn chế khi triển khai Batch Normalization

Mặc dù Batch Normalization mang lại nhiều lợi ích cho quá trình huấn luyện mô hình học sâu, nhưng việc triển khai kỹ thuật này cũng gặp phải một số thách thức và hạn chế sau:

- Phụ thuộc vào batch size: Batch Norm hoạt động dựa trên thống kê (trung bình và phương sai) tính trên từng mini-batch. Khi batch size quá nhỏ, thống kê tính được có thể không đại diện, làm giảm hiệu quả chuẩn hóa.

- Không phù hợp với một số mô hình tuần tự: Trong các mô hình như RNN, nơi mỗi bước phụ thuộc vào đầu ra của bước trước, việc áp dụng Batch Normalization có thể không hiệu quả hoặc gây khó khăn khi triển khai.

- Tăng độ phức tạp tính toán: Việc tính toán các thống kê trong mỗi batch có thể làm tăng thời gian xử lý và tiêu tốn tài nguyên, đặc biệt trong các hệ thống có phần cứng hạn chế.

Tạm kết

Qua bài viết trên, VNPT AI đã giúp bạn đọc giải mã Batch Normalization là gì và nguyên lý hoạt động của công nghệ này. Batch Normalization không chỉ giúp quá trình huấn luyện mô hình diễn ra ổn định và nhanh hơn, mà còn góp phần cải thiện khả năng tổng quát hóa và giảm phụ thuộc vào khâu khởi tạo trọng số. Dù vẫn tồn tại một số hạn chế nhất định, đặc biệt trong trường hợp batch size nhỏ, nhưng với những lợi ích vượt trội, Batch Normalization vẫn là một trong những kỹ thuật chuẩn hóa quan trọng và phổ biến trong lĩnh vực học sâu hiện nay.

25/06/2025

25/06/2025