Trong các mô hình trí tuệ nhân tạo (AI), Softmax function được xem là bước quan trọng giúp chuyển đổi đầu ra của mô hình thành xác suất có thể diễn giải được. Thông qua cơ chế này, AI có thể hiểu và phân loại dữ liệu hiệu quả hơn, đảm bảo sự ổn định cho quá trình huấn luyện. Vậy Softmax function là gì, hoạt động ra sao và tại sao nó lại được ứng dụng rộng rãi đến vậy? Hãy cùng VNPT AI đi tìm hiểu!

Softmax function là gì?

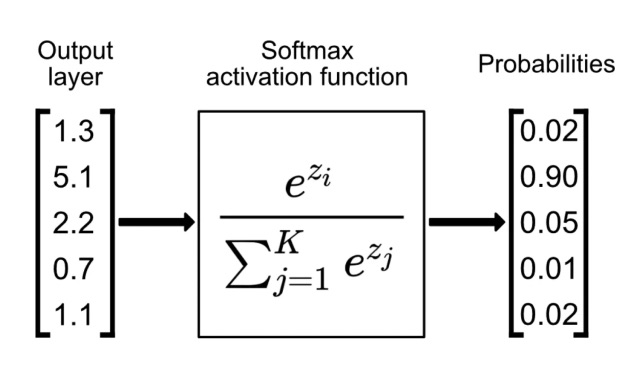

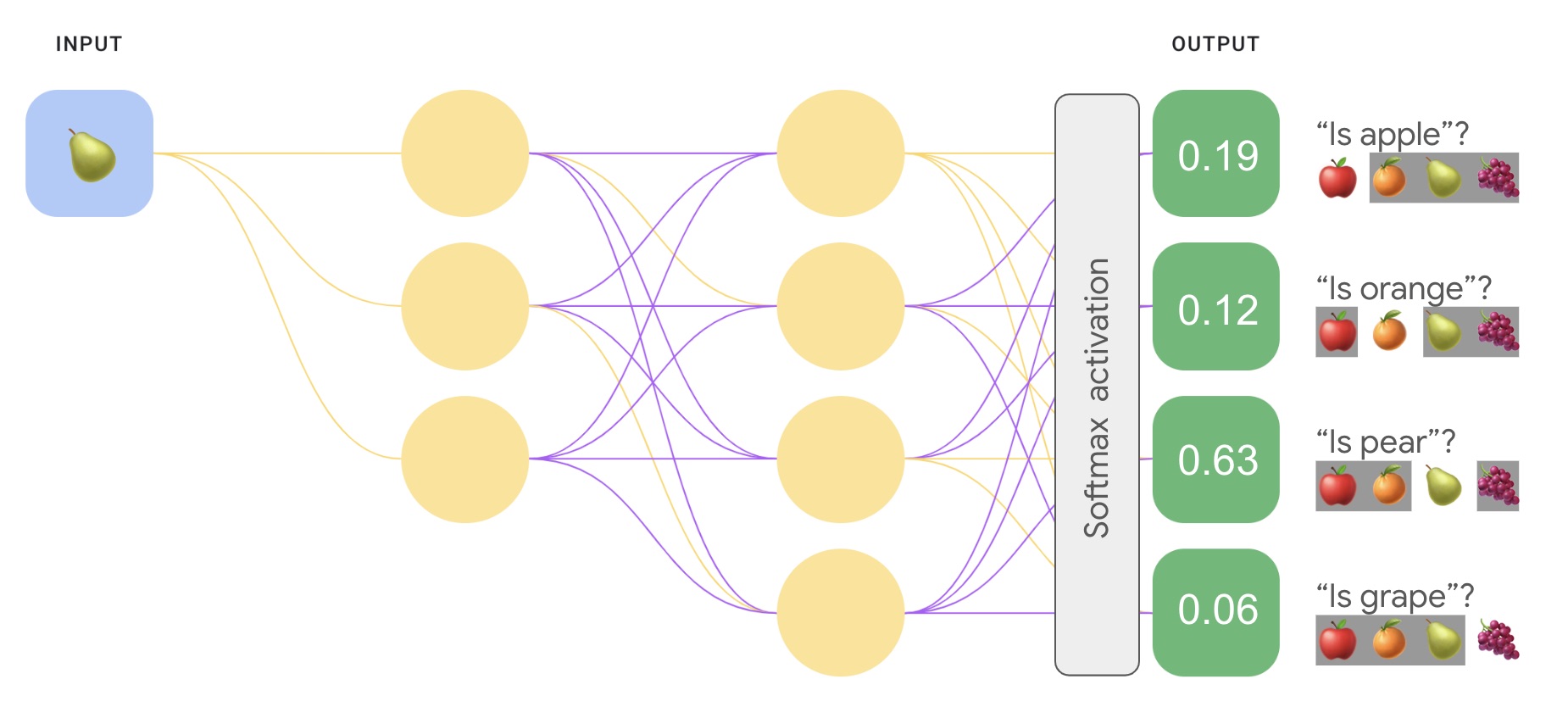

Softmax function là một hàm toán học thường được sử dụng trong lớp cuối cùng của mạng nơ-ron cho các bài toán phân loại. Hàm này có vai trò chuyển đổi một vector các giá trị đầu ra (logits) thành một phân phối xác suất, trong đó mỗi giá trị nằm trong khoảng (0,1) và tổng tất cả bằng 1. Nhờ đó, các giá trị có thể được diễn giải như xác suất mô hình gán cho từng lớp.

Công thức tổng quát của hàm Softmax được định nghĩa như sau:

σ(z)i=∑j=1Kezjezi

Trong đó:

- zi là giá trị đầu vào ứng với lớp i

- ezi là hàm mũ của zi

- Mẫu số ∑j=1Kezi là tổng của tất cả giá trị mũ trong vector đầu vào

Cách hoạt động của Softmax function

Softmax function hoạt động bằng cách chuyển đổi logits thô của mạng nơ-ron thành một phân phối xác suất hợp lệ. Quá trình này diễn ra theo các bước cơ bản như sau:

- Bước 1 – Tính hàm mũ của logits: Mỗi giá trị đầu vào zi được mũ hóa ezi. Việc này giúp tất cả các giá trị trở nên dương và làm tăng sự khác biệt giữa chúng.

- Bước 2 – Chuẩn hóa giá trị: Các giá trị mũ được chia cho tổng tất cả giá trị mũ trong vector đầu vào. Nhờ đó, tổng các kết quả luôn bằng 1, tạo thành một phân phối xác suất hợp lệ.

- Bước 3 – Diễn giải kết quả: Đầu ra của Softmax là một vector xác suất. Mỗi phần tử trong vector thể hiện xác suất mô hình dự đoán đầu vào thuộc về một lớp cụ thể. Lớp có xác suất cao nhất sẽ được chọn làm nhãn dự đoán cuối cùng.

Ví dụ: Với các logits [1.5, 0.5, 0.1], sau khi áp dụng Softmax, thu được phân phối xác suất xấp xỉ [0.62, 0.23, 0.15].

=> Mô hình dự đoán mẫu đầu vào có 62% khả năng thuộc lớp đầu tiên.

Ưu nhược điểm của hàm Softmax

Hàm Softmax mang lại nhiều lợi ích quan trọng trong học máy, nhưng đồng thời cũng tồn tại một số hạn chế cần cân nhắc:

Ưu điểm của hàm Softmax

- Tạo phân phối xác suất rõ ràng: Softmax chuyển đổi logits thành các giá trị trong khoảng (0,1) với tổng bằng 1, giúp mô hình thể hiện mức độ tin cậy cho từng lớp dự đoán.

- Dễ dàng tích hợp vào quá trình huấn luyện: Do có tính khả vi, Softmax dễ dàng kết hợp với thuật toán lan truyền ngược, hỗ trợ tối ưu hóa mô hình bằng gradient descent (thuật toán dùng để tìm cực tiểu của một hàm số).

- Dễ diễn giải và truyền đạt: Kết quả dưới dạng xác suất trực quan hơn so với logits thô, giúp người dùng hoặc nhà nghiên cứu dễ dàng đưa ra đánh giá, phân tích và gỡ lỗi mô hình.

- Tính ổn định số: Softmax giúp đảm bảo sự nhất quán và ổn định trong quá trình huấn luyện mạng nơ-ron.

Nhược điểm của hàm Softmax

- Nhạy cảm với outliers: Các giá trị logits quá lớn có thể chi phối kết quả, khiến mô hình đưa ra dự đoán thiên lệch.

- Làm chậm quá trình huấn luyện: Với những lớp có xác suất nhỏ, gradient (vectơ chứa đạo hàm riêng của một hàm đa biến) rất bé, làm quá trình học diễn ra chậm hơn.

- Dự đoán quá tự tin: Trong một số trường hợp, Softmax có thể gán xác suất cao cho lớp sai, khiến mô hình đưa ra kết quả không chính xác nhưng lại rất thuyết phục.

- Chi phí tính toán cao: Quá trình mũ hóa và chuẩn hóa trở nên tốn kém khi xử lý tập dữ liệu lớn hoặc nhiều lớp.

- Không phù hợp cho bài toán multi-label: Softmax chỉ chọn một lớp có xác suất cao nhất, nên không thích hợp với các bài toán có nhiều nhãn cùng lúc.

Ứng dụng của Softmax function

Softmax function được ứng dụng rộng rãi trong nhiều lĩnh vực như:

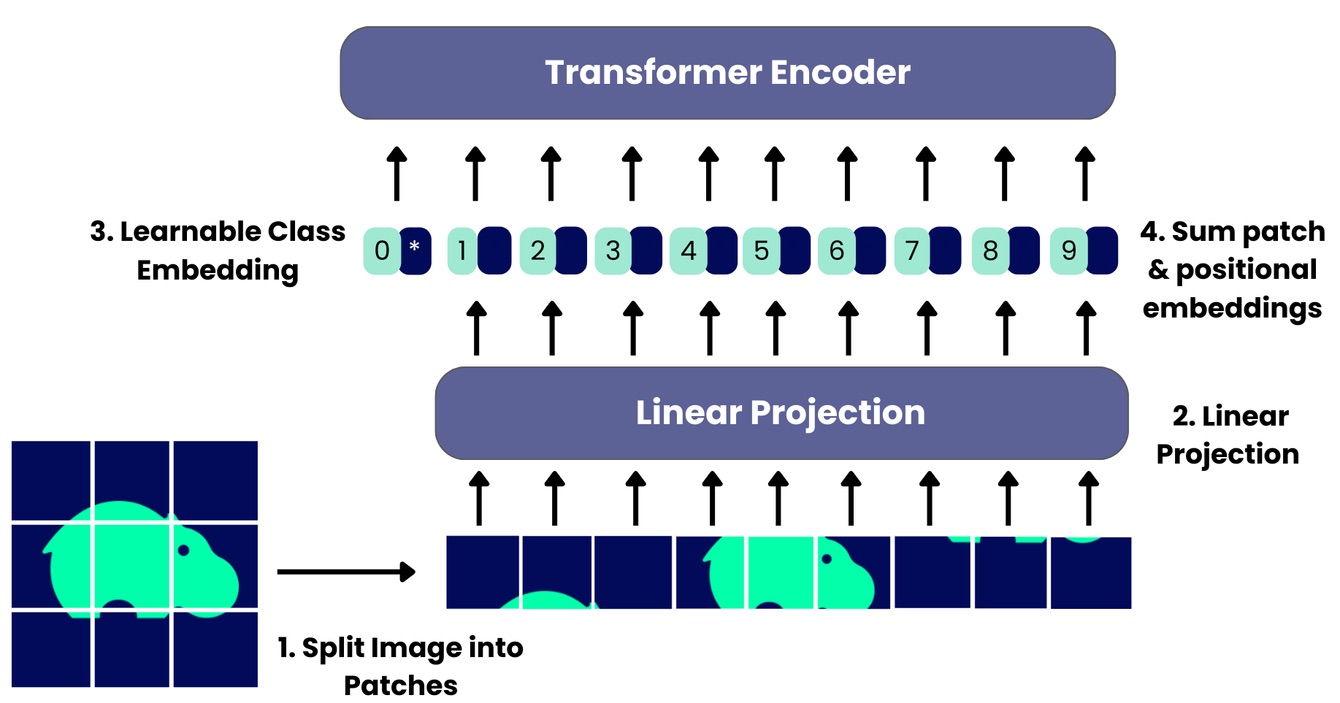

- Phân loại hình ảnh (Image Classification): Các mô hình như mạng nơ-ron tích chập (CNN) thường sử dụng Softmax ở lớp cuối để xác định xác suất một ảnh thuộc về từng lớp. Ví dụ, với ảnh thú cưng, mô hình có thể dự đoán {Chó: 0.9, Mèo: 0.08, Thỏ: 0.02}, cho thấy mức độ tin cậy trong kết quả.

- Xử lý ngôn ngữ tự nhiên (NLP): Trong các mô hình ngôn ngữ như Transformer, Softmax được dùng để dự đoán từ tiếp theo bằng cách chuyển đổi điểm số của toàn bộ từ vựng thành một phân phối xác suất. Đây chính là nền tảng cho nhiều ứng dụng hữu ích như: dịch máy, chatbot hay tạo lập văn bản,...

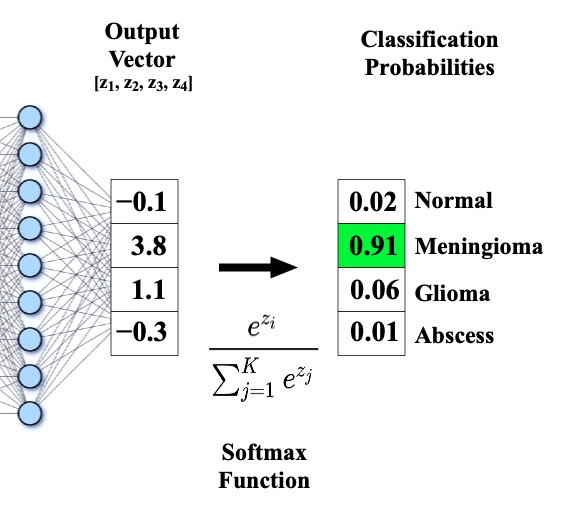

- Phân tích hình ảnh y tế: Khi phân loại mô hoặc chẩn đoán bệnh qua ảnh quét y khoa, Softmax giúp mô hình gán xác suất cho từng khả năng. Ví dụ: lành tính, ác tính, hoặc bình thường), từ đó hỗ trợ bác sĩ đưa ra quyết định chẩn đoán và điều trị chính xác hơn.

- Học tăng cường (Reinforcement Learning): Trong các thuật toán dựa trên chính sách, Softmax được dùng để chuyển đổi giá trị hành động thành phân phối xác suất, giúp tác nhân học cách đưa ra quyết định tối ưu.

Hàm Softmax khác gì so với các hàm activation còn lại?

Để hiểu rõ vai trò của Softmax function, và sự khác biệt của Softmax với các hàm activation phổ biến khác như Sigmoid, ReLU và Tanh, bạn có thể đánh giá thông qua bảng so sánh dưới đây:

Hàm Activation | Khoảng giá trị đầu ra | Ứng dụng chính | Hạn chế | Khả năng biểu diễn xác suất |

| Softmax | (0, 1), tổng các giá trị = 1 | Phân loại đa lớp (multi-class classification) | Nhạy cảm với outlier Tiêu tốn nhiều tài nguyên tính toán hơn | Có khả năng biểu diễn xác suất, chuyển đổi thành phân phối xác suất |

| Sigmoid | (0, 1) | Phân loại nhị phân (binary classification), phân loại đa lớp (multi-label classification) | Không đảm bảo tổng xác suất = 1 Dễ gây gradient vanish (suy giảm đạo hàm) | Có khả năng biểu diễn nhưng chỉ phù hợp cho nhị phân hoặc nhiều nhãn đồng thời |

| ReLU | [0, +∞) | Lớp ẩn trong mạng sâu, giúp học phi tuyến | Không tạo xác suất Dễ gặp vấn đề “chết ReLU” | Không |

| Tanh | (-1, 1) | Lớp ẩn, thường dùng trong RNN (Recurrent Neural Networks - mạng nơ-ron hồi quy) cũ | Không biểu diễn xác suất Dễ gây gradient vanish | Không |

Kết luận: So với các hàm activation khác, Softmax nổi bật hơn bởi khả năng chuẩn hóa đầu ra thành phân phối xác suất với tổng bằng 1, điều mà Sigmoid, ReLU hay Tanh không thể đáp ứng. Chính vì vậy, Softmax đặc biệt phù hợp cho bài toán phân loại đa lớp, nơi mỗi mẫu chỉ thuộc về một lớp duy nhất.

Tạm kết

Thông qua những kiến thức được VNPT AI tổng hợp trên đây, có thể thấy, Softmax function giữ vai trò quan trọng trong các mô hình AI hiện đại. Hàm này giúp mô hình biểu diễn kết quả dự đoán một cách dễ hiểu hơn và duy trì tính ổn định trong quá trình huấn luyện. Nhờ khả năng này, Softmax góp phần hoàn thiện hiệu suất của các hệ thống phân loại và dự đoán, đồng thời tạo nền tảng cho sự phát triển của trí tuệ nhân tạo.

22/11/2025

22/11/2025