Tối ưu hóa Phát hiện Vật thể từ camera mắt cá cho Thiết bị Biên

Camera fisheye đang trở thành giải pháp quan trọng trong giám sát đô thị thông minh nhờ khả năng bao phủ không gian rộng. Tuy nhiên, biến dạng ống kính và giới hạn tài nguyên thiết bị biên khiến bài toán phát hiện vật thể trở nên thách thức. Bài viết chia sẻ cách VNPT AI tối ưu phát hiện vật thể camera fisheye trên thiết bị biên, đảm bảo độ chính xác cao và xử lý thời gian thực.

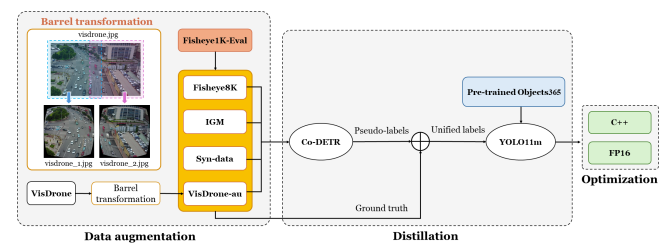

Việc triển khai các bộ phát hiện vật thể (object detectors) trên camera mắt cá (fisheye camera) cho mục đích giám sát thành phố thông minh đối diện với hai thách thức cốt lõi: xử lý biến dạng ống kính cực độ và đáp ứng ngân sách thời gian thực nghiêm ngặt trên các GPU biên (edge GPUs) bị hạn chế tài nguyên. Đội ngũ chuyên gia VNPT AI đã phát triển một quy trình làm việc (pipeline) mô hình đơn lẻ, tích hợp chiến lược tăng cường dữ liệu (augmentation), chưng cất tri thức (distillation) và tối ưu hóa phần cứng-nhận biết (hardware-aware optimization).

Giải pháp này đã thiết lập một tiêu chuẩn thực hành mới bằng cách vượt qua rào cản 60% F1 đã tồn tại lâu dài và duy trì tốc độ 25 Khung hình/giây (FPS) trên thiết bị NVIDIA Jetson AGX Orin. Những kết quả này chứng minh rằng việc tích hợp chặt chẽ tối ưu hóa phần cứng, tăng cường dữ liệu và chưng cất tri thức từ mô hình nền tảng là chìa khóa để đạt được hiệu suất phát hiện vật thể vừa chính xác vừa hiệu quả trên thiết bị biên.

.jpg)

Nhu cầu Giám sát Đô thị và Thách thức Fisheye

Sự phát triển của cơ sở hạ tầng thành phố thông minh tạo ra nhu cầu cấp thiết về các giải pháp giám sát an ninh và giao thông toàn diện. Tại các địa điểm quan trọng như nút giao thông, việc lắp đặt nhiều camera truyền thống để đạt độ phủ sóng hoàn chỉnh làm tăng chi phí cơ sở hạ tầng và độ phức tạp xử lý dữ liệu.

Camera mắt cá đã trở thành một giải pháp tiềm năng để giải quyết các hạn chế về phạm vi phủ sóng. Đặc tính ống kính của chúng cung cấp trường nhìn đa hướng lên tới 180 độ hoặc thậm chí 360 độ chỉ với một thiết bị duy nhất, từ đó giảm đáng kể số lượng camera cần thiết.

Tuy nhiên, ứng dụng camera mắt cá trong phát hiện vật thể gặp phải nhiều trở ngại do đặc tính biến dạng xuyên tâm (radial distortion) cố hữu của ống kính. Biến dạng này gây ra những thay đổi nghiêm trọng về tỷ lệ, hình dạng và phối cảnh ở ngoại vi hình ảnh, làm suy giảm nghiêm trọng hiệu suất của các mô hình phát hiện vật thể tiêu chuẩn.

Thách thức còn tăng lên khi hệ thống này được triển khai trên các thiết bị biên (edge devices). Những ràng buộc về tài nguyên tính toán, bộ nhớ và yêu cầu xử lý thời gian thực đòi hỏi các phương pháp tiếp cận chuyên biệt để đảm bảo hiệu suất triển khai. Đặc biệt, AI City Challenge 2025 – Track 4 đưa ra giới hạn thời gian thực nghiêm ngặt, yêu cầu duy trì tốc độ 10 FPS trên NVIDIA Jetson Orin AGX (30W). Điều này đã thúc đẩy đội ngũ chuyên gia VNPT AI tập trung vào việc thiết kế một quy trình nhỏ gọn nhưng chính xác, xoay quanh bộ phát hiện YOLO11m chỉ 20 triệu tham số.

Phương pháp tiếp cận: Tích hợp Augmentation, Distillation và Optimization

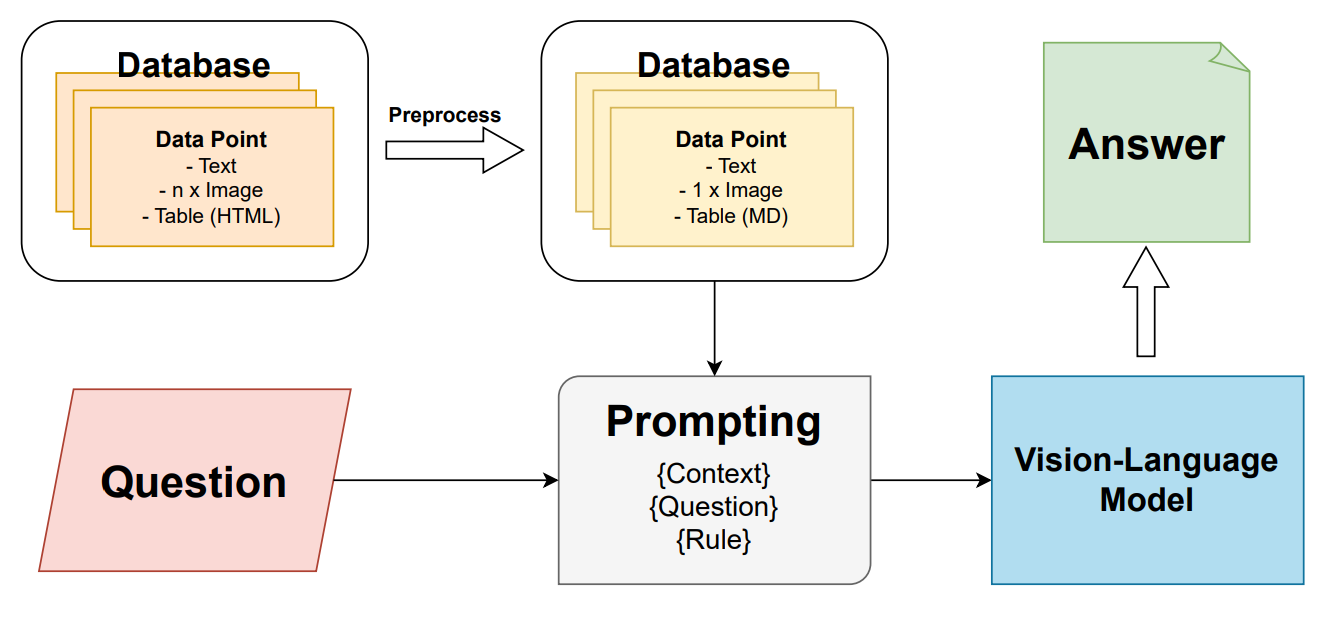

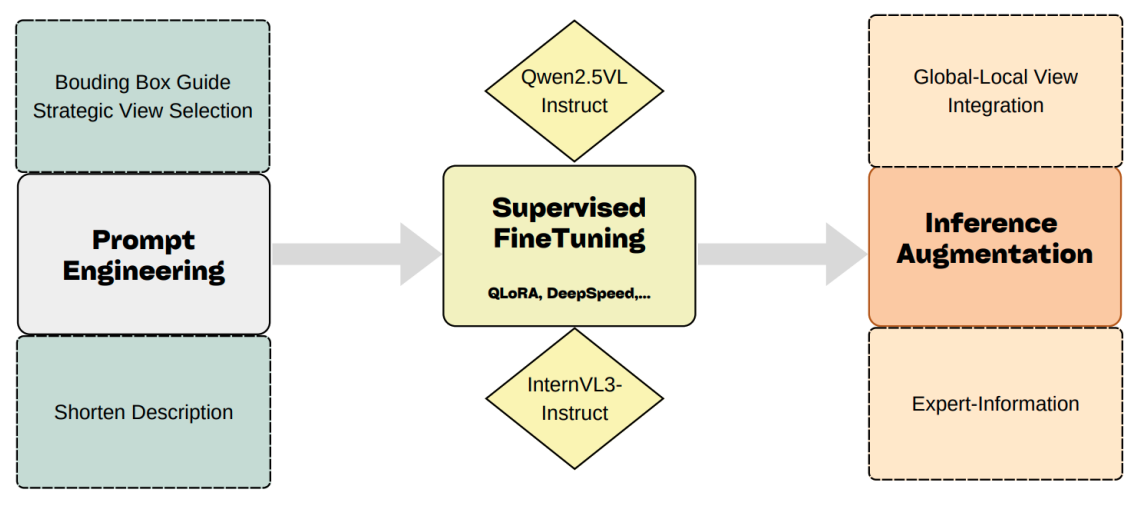

Giải pháp của chúng tôi được xây dựng trên ba trụ cột chính, được minh họa trong quy trình làm việc tổng thể.

Chiến lược Tăng cường Dữ liệu Fisheye-Aware (Augmentation)

Để tăng cường khả năng tổng quát hóa của mô hình trên các bộ dữ liệu đa dạng, chúng tôi đã áp dụng một chiến lược tăng cường dữ liệu đa chiều.

- Chuyển đổi Fisheye-Aware (Barrel Transformation): Các bộ dữ liệu thông thường như VisDrone không tương thích với đặc điểm biến dạng của dữ liệu fisheye. Chúng tôi đã phát triển các phương pháp chuyển đổi chuyên biệt, áp dụng biến đổi thùng (Barrel transformation) lên hình ảnh từ VisDrone để mô phỏng sự biến dạng của camera mắt cá. Những hình ảnh đã được chuyển đổi này được gọi là VisDrone-au.

- Tiền Huấn luyện Lớn (Large-Scale Pre-Training): Thay vì khởi tạo mô hình bằng trọng số được huấn luyện trên COCO, chúng tôi sử dụng trọng số được tiền huấn luyện trên Objects365. Objects365 chứa 1.74 triệu hình ảnh bao gồm 365 lớp—gấp hơn bốn lần độ rộng danh mục của COCO—cung cấp các tri thức ngữ cảnh phong phú hơn, giúp tăng cường khả năng tổng quát hóa miền chéo. Thực nghiệm cho thấy, tiền huấn luyện Objects365 giúp cải thiện hiệu suất của YOLO11m thêm +2.0 mAP.

>>> Đọc thêm: Phương pháp tăng cường dữ liệu phát hiện đối tượng ở ảnh chụp camera mắt cá

Chưng cất Tri thức Dữ liệu-Trung tâm (Knowledge Distillation)

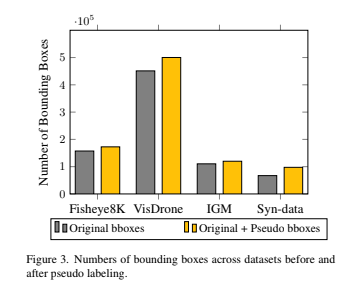

Nhiều bộ dữ liệu hiện có, bao gồm VisDrone, không có đủ nhãn cho tất cả các vật thể trong hình ảnh. Để giải quyết vấn đề thiếu nhãn (missing objects), chúng tôi đã tận dụng nhãn giả (pseudo-labels) chất lượng cao được tạo ra bởi mô hình teacher mạnh mẽ Co-DETR.

Quá trình này hoạt động như một quá trình chưng cất tri thức ngoại tuyến (offline knowledge distillation), trong đó mô hình Co-DETR dung lượng lớn truyền sự giám sát dày đặc (dense supervision) sang mô hình student nhẹ hơn là YOLO11m. Các nhãn giả được chọn có điểm tin cậy (confidence score) lớn hơn 0.4 và Intersection over Union (IoU) với bất kỳ hộp giới hạn thật nào nhỏ hơn 0.5. Việc bổ sung nhãn giả đã làm tăng đáng kể số lượng hộp giới hạn trong các bộ dữ liệu huấn luyện.

Tối ưu hóa Thiết bị Biên (Edge-Aware Optimization)

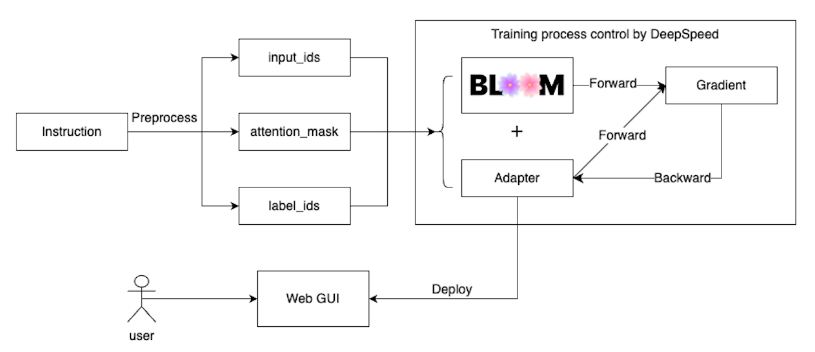

Để đáp ứng yêu cầu suy luận thời gian thực trên NVIDIA Jetson AGX Orin 64GB, đội ngũ chuyên gia VNPT AI đã triển khai các kỹ thuật tối ưu hóa phần cứng-nhận biết (hardware-aware optimization).

- Lựa chọn Mô hình và Độ phân giải: Kiến trúc YOLO11m đã được chọn do đạt được sự cân bằng vượt trội giữa độ phức tạp mô hình (20M tham số) và hiệu suất phát hiện, sử dụng ít hơn 22% tham số so với YOLOv8m. Chúng tôi sử dụng kích thước đầu vào 960x960 để cân bằng hiệu quả giữa tốc độ suy luận và độ chính xác.

- Tối ưu hóa Suy luận: Pipeline suy luận được triển khai bằng C++ với tối ưu hóa chính xác NVIDIA TensorRT FP16, thay vì suy luận dựa trên Python truyền thống. Việc sử dụng C++ giúp loại bỏ chi phí của trình thông dịch Python và cung cấp khả năng quản lý bộ nhớ trực tiếp, từ đó giảm đáng kể độ trễ suy luận.

Sự tối ưu hóa phần cứng-nhận biết này đã giảm một nửa độ trễ đầu cuối (từ 124.6 ms xuống 38.8 ms) và đảm bảo thông lượng thời gian thực ổn định ở mức 25 FPS trên Jetson AGX Orin 64GB.

>>> Tìm hiểu thêm: YOLO là gì?

Kết quả Vượt trội trên Thiết bị Biên

Quy trình tích hợp Augmentation, Distillation và Optimization của VNPT AI đã mang lại hiệu suất vượt trội, đặc biệt trong bối cảnh AI City Challenge 2025 - Track 4, nơi độ chính xác và tốc độ thời gian thực là yếu tố quyết định.

Chiến lược tăng cường dữ liệu và nhãn giả đã cung cấp sự cải thiện đáng kể, nâng mAP từ mức cơ sở (chỉ sử dụng Fisheye8K) 31.1% lên tới 45.1% khi kết hợp VisDrone-au, nhãn giả, và các nguồn dữ liệu bổ sung. Cụ thể, chiến lược tăng cường dữ liệu đã mang lại mức tăng +16.1% mAP.

Mô hình cuối cùng, YOLO11m+pseudo+finetune, chỉ với 20M tham số, đã đạt được F1-score 63.42% và duy trì tốc độ 25 FPS. Kết quả này tiệm cận hiệu suất F1-score (64.06%) của mô hình ensemble với tổng số 2000M tham số, trong khi vượt trội hơn mô hình Co-DETR+pseudo (304M tham số, 62.46% F1). Điều này chứng tỏ hiệu quả của việc tập trung vào tối ưu hóa kiến trúc nhẹ.

Sự tối ưu hóa biên (Edge-aware optimization) đã giúp mô hình đạt Metric 0.6370 (được định nghĩa là trung bình điều hòa giữa F1 và FPS đã chuẩn hóa).

Kết luận

Giải pháp "Augmentation, Distillation and Optimization" của đội ngũ chuyên gia VNPT AI đã thiết lập một phương pháp tiếp cận cân bằng hiệu quả giữa độ chính xác và tốc độ xử lý cho tác vụ phát hiện vật thể trên camera mắt cá.

Thành công này dựa trên sự tích hợp đồng bộ giữa việc xử lý biến dạng ống kính thông qua chuyển đổi Barrel, tăng cường chất lượng dữ liệu bằng cách chưng cất tri thức từ mô hình nền tảng mạnh mẽ (Co-DETR), và tối ưu hóa suy luận cấp độ phần cứng (C++/TensorRT FP16). Chiến lược này không chỉ đạt được F1-score 63.42% mà còn duy trì tốc độ 25 FPS trên NVIDIA Jetson AGX Orin 64GB, giải quyết triệt để yêu cầu về hiệu suất thời gian thực trong môi trường giám sát đô thị thông minh.

Tin mới nhất

VNPT AI

Hãy trở thành đối tác của chúng tôi ngay hôm nay để được sử dụng những dịch vụ hàng đầu!

Gửi lời nhắnĐánh Giá