Tối ưu hóa LLM đa ngôn ngữ: Phát triển Chatbot GenAI cho doanh nghiệp SMEs

Trong bối cảnh Trí tuệ nhân tạo tạo sinh (GenAI) đang thay đổi toàn diện các ngành nghề, nhu cầu về một giải pháp LLM đa ngôn ngữ mạnh mẽ và linh hoạt là vô cùng cấp thiết. Nhận thức rõ điều này, các chuyên gia của VNPT AI đã phát triển mô hình Expert-B dựa trên kiến trúc BLOOM. Đây là giải pháp tối ưu hóa quy trình huấn luyện bằng kỹ thuật LoRA và DeepSpeed, giúp tiết kiệm tài nguyên tính toán nhưng vẫn đảm bảo hiệu suất vượt trội trên cả tiếng Anh và tiếng Việt.

Trí tuệ Nhân tạo tạo sinh (GenAI) và các ứng dụng Mô hình Ngôn ngữ Lớn (LLM) như ChatGPT đang đóng vai trò quan trọng trong nhiều lĩnh vực, từ quản lý đô thị thông minh (Smart Cities) đến tự động hóa các dịch vụ. GenAI được coi là một đổi mới đột phá (Disruptive Innovation - DI) có tiềm năng thay đổi nhiều vai trò công việc và ngành nghề.

Việc thiết kế và phát triển các hệ thống GenAI quy mô lớn đòi hỏi một nguồn đầu tư lớn về tài chính, công nghệ, tính toán và nhân lực. Bản chất tiêu tốn tài nguyên này giới hạn khả năng các Doanh nghiệp Vừa và Nhỏ (SMEs) có thể áp dụng mô hình GenAI phù hợp. Việc tìm kiếm một giải pháp cho vấn đề này là cực kỳ quan trọng, bởi vì Chatbot GenAI có thể mang lại những lợi ích đáng kể về mặt tổ chức và thương mại cho mọi loại hình doanh nghiệp.

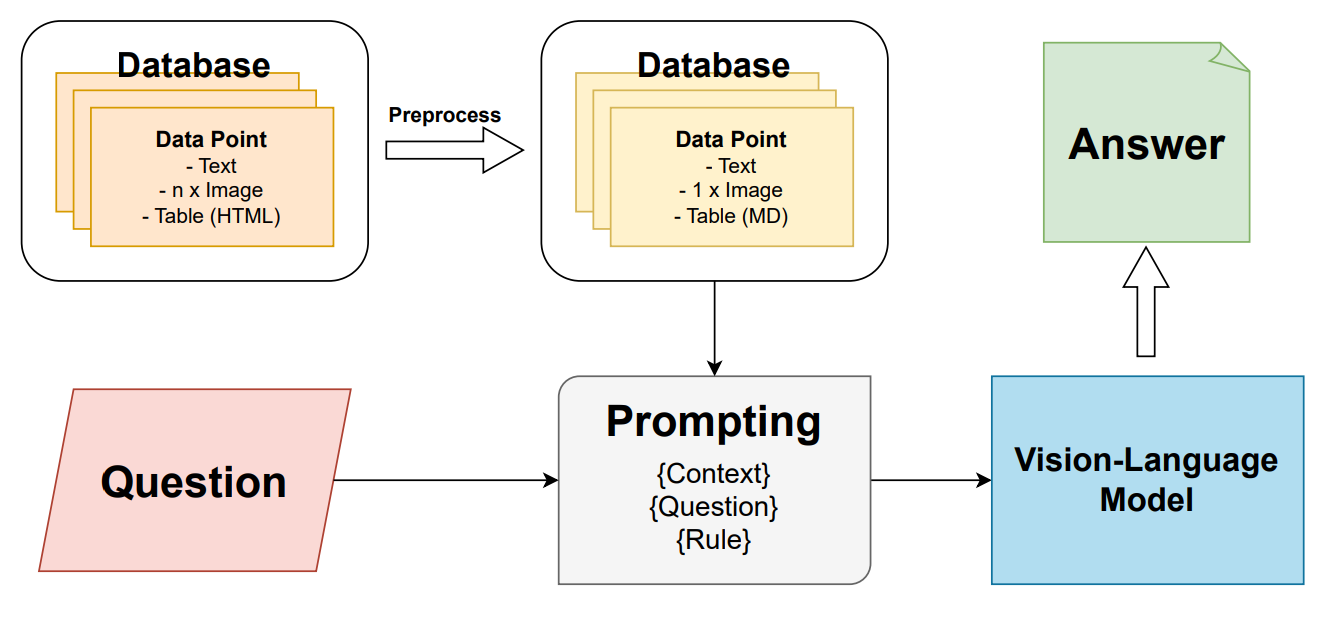

Nhận thức rõ thách thức này, chuyên gia của VNPT AI đã nghiên cứu và đề xuất một phương pháp tiếp cận mới, tập trung vào việc phát triển LLM sử dụng GenAI, được thiết kế đặc biệt để tự động hóa các tương tác hỏi-đáp chuyên biệt trong các lĩnh vực cụ thể, phù hợp với các SMEs có cơ sở hạ tầng phần cứng hạn chế.

Expert-B: Giải Pháp LLM Tối Ưu Cho Hạ Tầng SMEs

Mô hình mang tên Expert-B sử dụng kiến trúc mã nguồn mở BLOOM làm nền tảng cốt lõi. Mục tiêu của Expert-B là tạo ra một chatbot đa ngôn ngữ linh hoạt, có khả năng thích ứng với nhiều ngôn ngữ, tập trung ban đầu vào Tiếng Anh và Tiếng Việt. Mô hình này được thiết kế để triển khai trên các máy chủ GPU cỡ trung bình, phù hợp với cơ sở hạ tầng của SMEs.

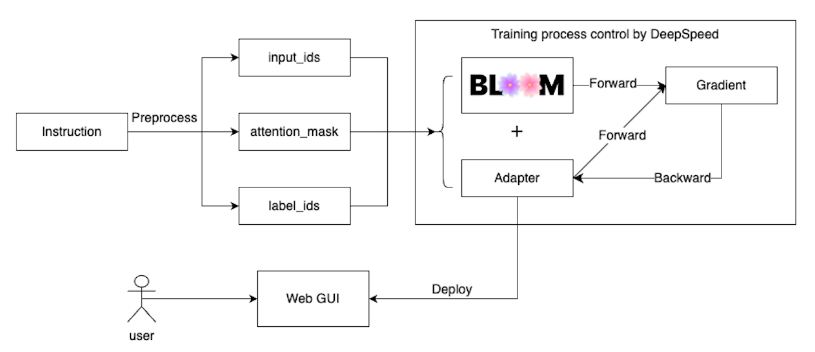

Tối Ưu Hóa Chi Phí và Thời Gian Huấn Luyện Bằng LoRA và DeepSpeed

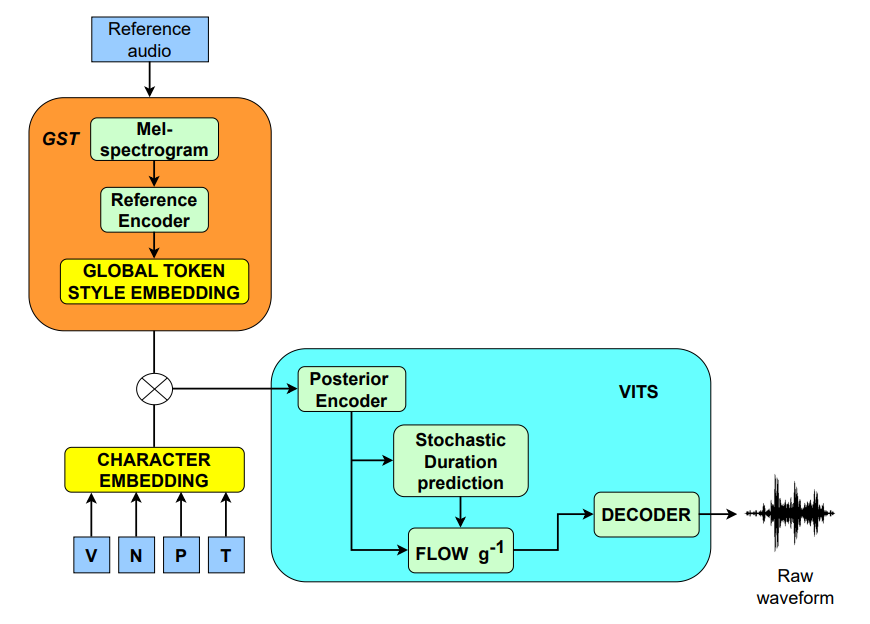

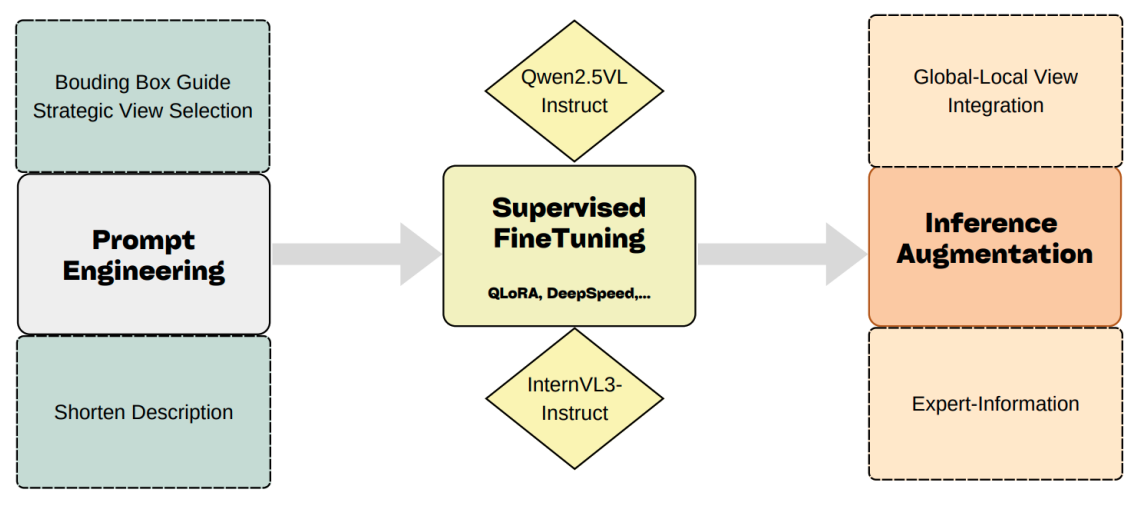

Để giải quyết vấn đề chi phí và tài nguyên tính toán cao, chuyên gia VNPT AI đã tối ưu hóa quy trình huấn luyện LLM bằng cách kết hợp hai kỹ thuật hàng đầu: Low-Rank Adaptation (LoRA) và DeepSpeed ZeRO-offload.

1. Giảm Tham Số Hiệu Quả với LoRA

Low-Rank Adaptation (LoRA) là một kỹ thuật Tinh chỉnh Tham số Hiệu quả (Parameter-Efficient Fine-Tuning - PEFT) giúp giảm đáng kể số lượng tham số cần huấn luyện trong khi vẫn duy trì hiệu suất mô hình. Trong một số trường hợp, PEFT thậm chí có thể vượt qua các phương pháp fine-tuning truyền thống.

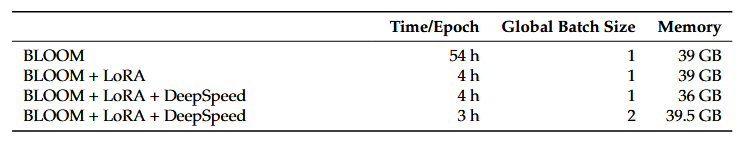

Khi áp dụng LoRA cho mô hình nền tảng BLOOM-7B1 (phiên bản 7 tỷ tham số), số lượng tham số cần huấn luyện chỉ còn khoảng 7.5 triệu tham số, tương đương chỉ 0.11% tổng số tham số ban đầu. Sự tối ưu này đã mang lại sự cải thiện vượt trội về thời gian:

- Thời gian huấn luyện một epoch (100k mẫu) trên một GPU NVIDIA A100 40 GB ban đầu là 54 giờ.

- Với LoRA, thời gian này giảm xuống còn 4 giờ/epoch.

Việc giảm thời gian huấn luyện nhanh hơn gần 14 lần này giúp đánh giá bộ dữ liệu và thực hiện fine-tuning hiệu quả hơn rất nhiều.

2. Tối Ưu Bộ Nhớ GPU với DeepSpeed ZeRO-Offload

Chuyên gia VNPT AI kết hợp DeepSpeed ZeRO-Offload để tối ưu hóa quy trình huấn luyện phân tán và giảm áp lực lên bộ nhớ GPU VRAM. DeepSpeed cho phép phân vùng các trạng thái mô hình (trạng thái tối ưu hóa, gradient và tham số) thay vì nhân bản chúng trên các tiến trình song song dữ liệu.

DeepSpeed với cơ chế offload cho phép tăng kích thước lô (batch size) từ 1 lên 2. Kết quả là thời gian huấn luyện cho một epoch tiếp tục giảm xuống chỉ còn 3 giờ trên một GPU NVIDIA A100 40 GB. Tổng cộng, quy trình tối ưu hóa này đã giúp giảm thời gian huấn luyện tới 18 lần so với phương pháp huấn luyện thông thường.

Kết Quả Đánh Giá: Hiệu Suất Vượt Trội Trên Chuẩn Tiếng Việt

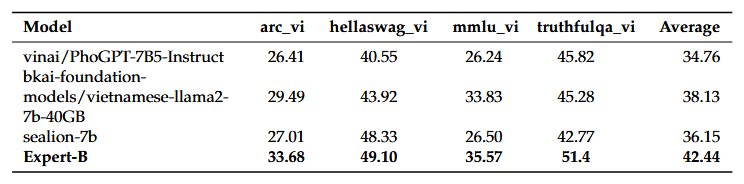

Mô hình Expert-B đã được thử nghiệm trên bộ dữ liệu Vicuna và chuẩn VLSP-LLM 2023, cho thấy hiệu suất cạnh tranh mạnh mẽ, đặc biệt là trong lĩnh vực ngôn ngữ Việt Nam.

So Sánh Hiệu Suất Đa Ngôn Ngữ

Trong thử nghiệm so sánh với mô hình chatbot đa ngôn ngữ 'Phoenix' (cũng dựa trên BLOOM), Expert-B đã thể hiện sự vượt trội:

- Expert-B đạt hiệu suất 92% so với ChatGPT trên chuẩn Tiếng Anh.

- Khi so sánh trực tiếp với Phoenix trên chuẩn Tiếng Anh, Expert-B đạt hiệu suất 107.89%, vượt qua Phoenix. Expert-B giành chiến thắng trong 51/80 hạng mục câu hỏi so với 29 chiến thắng của Phoenix trong chuẩn Tiếng Anh.

Thống Trị Trên Chuẩn VLSP-LLM 2023 Tiếng Việt

Điều đáng chú ý là hiệu suất của Expert-B trên bộ tiêu chuẩn dành riêng cho Tiếng Việt VLSP-LLM 2023. Trong phân tích so sánh với các mô hình Tiếng Việt khác (bao gồm Vinai/PhoGPT-7B5-Instruct và SeaLLM-7B), Expert-B đã chứng minh hiệu suất vượt trội hơn tất cả các mô hình được so sánh, đạt điểm trung bình 42.44.

Thành tựu này khẳng định tính hiệu quả của phương pháp tinh chỉnh (fine-tuning) được áp dụng, chứng minh khả năng tận dụng dữ liệu huấn luyện để đạt kết quả xuất sắc, ngay cả khi Expert-B không trải qua quá trình tiền huấn luyện liên tục bằng Tiếng Việt như một số đối thủ.

Đề xuất vị trí ảnh 3: Bảng Điểm Chuẩn VLSP

(Nên chèn bảng so sánh kết quả VLSP-LLM 2023 (tương đương Table 5 trong nguồn) để nhấn mạnh sự vượt trội của Expert-B trên chuẩn Tiếng Việt).

Kết Luận và Tầm Nhìn Tương Lai

Mô hình Expert-B là một đóng góp quan trọng, cung cấp một nền tảng hiệu quả và tiết kiệm chi phí để các SMEs thực hiện chatbot GenAI tùy chỉnh, chuyên biệt hóa theo lĩnh vực. Phương pháp này giúp tận dụng tối đa tiềm năng của GenAI cho các doanh nghiệp bị giới hạn về nguồn lực.

Trong tương lai, đội ngũ chuyên gia VNPT AI sẽ tiếp tục nghiên cứu các hướng cải tiến để nâng cao chất lượng và độ an toàn của mô hình, bao gồm:

- Tích hợp RLHF: Thiết kế hệ thống Học tăng cường từ Phản hồi của Con người (Reinforcement Learning from Human Feedback - RLHF) để cải thiện chất lượng, tính hữu ích và độ an toàn của phản hồi.

- Thay thế kiến trúc nền tảng: Cân nhắc thay thế BLOOM bằng các mô hình mới hơn, có hiệu suất cao hơn như LLaMA hoặc Mistral để tối ưu hóa hiệu suất hơn nữa.

Mục tiêu cuối cùng của chúng tôi là xây dựng một trợ lý ảo đạt chất lượng tương đương ChatGPT chỉ bằng các tài nguyên mã nguồn mở và chi phí tính toán tối thiểu, phục vụ cho các ứng dụng trong lĩnh vực đô thị thông minh và các ngành nghề đa dạng.

Tin mới nhất

VNPT AI

Hãy trở thành đối tác của chúng tôi ngay hôm nay để được sử dụng những dịch vụ hàng đầu!

Gửi lời nhắnĐánh Giá