Với hơn 1 tỷ lượt tải xuống tính đến tháng 3 năm 2025, LLaMA đã nhanh chóng trở thành một trong những mô hình ngôn ngữ mở phổ biến nhất trên thế giới. Con số ấn tượng này không chỉ phản ánh sức hút của mô hình này đối với từ cộng đồng nhà phát triển, doanh nghiệp và các tổ chức nghiên cứu mà còn khẳng định vị thế vượt trội của LLaMA trong cuộc đua trí tuệ nhân tạo. Vậy LLaMA là gì và điều gì đã giúp mô hình này đạt được thành công như vậy? Hãy cùng VNPT AI khám phá chi tiết trong bài viết dưới đây.

LLaMA là gì?

LLaMA (Large Language Model Meta AI) là một dòng mô hình ngôn ngữ lớn tiên tiến do Meta phát triển. Dòng mô hình này bao gồm các phiên bản với số lượng tham số từ 7 tỷ đến 65 tỷ. Mặc dù có kích thước nhỏ hơn so với nhiều mô hình AI khác cùng phân khúc, LLaMA vẫn mang lại hiệu suất xử lý ngôn ngữ đáng kể, giúp tiết kiệm đáng kể tài nguyên tính toán trong quá trình nghiên cứu, thử nghiệm và triển khai các ứng dụng AI thực tiễn.

LLaMA được huấn luyện trên một tập dữ liệu khổng lồ, không gắn nhãn, bao gồm nhiều nguồn thông tin đa dạng. Cụ thể:

- 67% từ CommonCrawl

- 15% từ bộ dữ liệu C4

- 4,5% từ GitHub

- 4,5% từ Wikipedia

- 4,5% từ các đầu sách

- 2,5% từ ArXiv (kho học thuật mở)

- 2% từ StackExchange

Từ năm 2024 trở đi, Meta đã phát hành LLaMA 2 và LLaMA 3 với quy mô lớn hơn và chất lượng dữ liệu được cải thiện đáng kể.

Sự đa dạng của nguồn dữ liệu giúp mô hình LLaMA đạt hiệu năng vượt trội, từng đủ sức cạnh tranh với các mô hình ngôn ngữ hàng đầu ở thời điểm ra mắt như Chinchilla-70B của DeepMind hay PaLM-540B của Google, trước khi các phiên bản mới hơn được phát triển. Nhờ khả năng huấn luyện từ dữ liệu nền rộng lớn và chưa gắn nhãn, LLaMA phù hợp để tinh chỉnh (fine-tune) cho nhiều tác vụ khác nhau, từ xử lý ngôn ngữ tự nhiên đến hỗ trợ lập trình, tạo nội dung hay trả lời câu hỏi tự động.

>>> Tìm hiểu thêm: Claude AI là gì?

Nguyên lý hoạt động của LLaMA

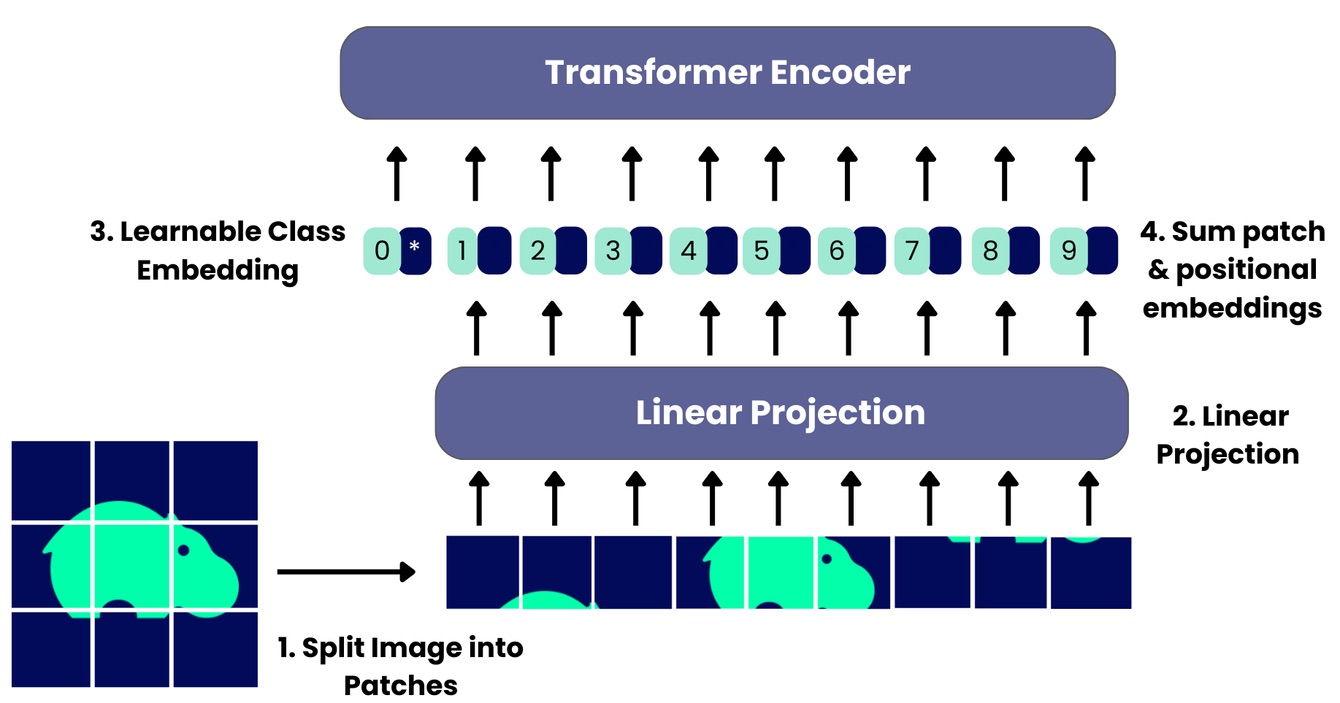

LLaMA là một mô hình ngôn ngữ tự hồi quy (auto-regressive) được xây dựng dựa trên kiến trúc Transformer – nền tảng phổ biến trong các mô hình AI hiện đại. Cơ chế hoạt động của LLaMA xoay quanh việc dự đoán từ tiếp theo trong chuỗi văn bản, dựa trên các từ cho trước. Bằng cách lặp lại quy trình này, mô hình có thể sinh ra đoạn văn bản liền mạch, logic và phù hợp với ngữ cảnh.

Điểm khác biệt của LLaMA so với nhiều mô hình khác là ở nguồn dữ liệu huấn luyện công khai và đa dạng ngôn ngữ. Mô hình được huấn luyện trên các văn bản thuộc nhiều ngôn ngữ như: tiếng Anh, Đức, Pháp, Tây Ban Nha, Nga, Ý và nhiều ngôn ngữ châu Âu khác. Nhờ đó, LLaMA có khả năng xử lý văn bản đa ngôn ngữ với độ chính xác cao.

Các phiên bản của LLaMA được Meta phát hành với nhiều quy mô tham số khác nhau, từ LLaMA 1 (7B–65B), LLaMA 2 (lên đến 70B) đến LLaMA 3 (lên tới 400B), cho phép người dùng lựa chọn linh hoạt theo mục đích sử dụng và năng lực tính toán. Mô hình LLaMA có thể được truy cập thông qua nền tảng Hugging Face (phiên bản đã chuyển đổi để dùng với thư viện Transformers) hoặc kho mã chính thức của Meta tại facebookresearch/llama.

Các phiên bản của LLaMA

Dưới đây là các phiên bản nổi bật của LLaMA qua từng giai đoạn phát triển:

LLaMA 1

Meta ra mắt LLaMA 1 vào tháng 2/2023 với bốn mô hình có quy mô từ 7B đến 65B tham số, sử dụng kiến trúc Transformer. Mô hình được huấn luyện trên 1,4 nghìn tỷ token từ các nguồn dữ liệu công khai như Common Crawl, GitHub và Wikipedia (20 ngôn ngữ). LLaMA 1 nổi bật nhờ hiệu suất cao nhưng tiết kiệm tài nguyên, cho kết quả tốt trên các bài đánh giá như đọc hiểu, suy luận và lập trình.

LLaMA 2

Ra mắt tháng 7/2023, LLaMA 2 được Meta phát hành theo giấy phép thương mại, kèm mã nguồn và trọng số giúp cộng đồng dễ dàng truy cập và phát triển. LLaMA 2 cải tiến về chất lượng và độ an toàn nhờ huấn luyện với 2 nghìn tỷ token, sử dụng thêm kỹ thuật học từ phản hồi người dùng (RLHF). Các phiên bản từ 7B đến 70B tham số có khả năng xử lý tốt hơn trong hội thoại (LLaMA 2-chat), đồng thời kiểm soát nội dung nhạy cảm hiệu quả hơn so với phiên bản đầu.

LLaMA 3

LLaMA 3 được Meta giới thiệu với hai phiên bản chính: 8B và 70B tham số, huấn luyện trên 15 nghìn tỷ token, trong đó hơn 5% là dữ liệu từ 30 ngôn ngữ khác nhau. Mô hình hỗ trợ ngữ cảnh dài tới 8.000 token và tương thích với nhiều loại phần cứng phổ thông.

Meta phát hành hai biến thể cho mỗi kích thước: phiên bản gốc (Base) và phiên bản tinh chỉnh theo tác vụ (Instruct). Bản Instruct được tối ưu để ứng dụng vào các tình huống cụ thể như trợ giảng, xử lý tài liệu pháp lý hay hỗ trợ nghiên cứu y sinh. Việc phân tách này giúp LLaMA 3 linh hoạt và hiệu quả hơn trong thực tế.

LLaMA 4

LLaMA 4 sử dụng kiến trúc tiên tiến gọi là Mixture of Experts (MoE). Mô hình gồm hai biến thể chính:

- Scout: 109B tham số, gồm 16 chuyên gia, kích hoạt 17B tham số mỗi lần.

- Maverick: 400B tham số, gồm 128 chuyên gia, cũng kích hoạt 17B tham số khi hoạt động.

Thay vì kích hoạt toàn bộ tham số như các mô hình truyền thống, LLaMA 4 áp dụng kiến trúc MoE, chỉ kích hoạt một phần nhỏ trong số các mô-đun chuyên biệt, gọi là “expert” (chuyên gia). Mỗi expert đảm nhiệm một mảng kiến thức hoặc kỹ năng nhất định. Khi xử lý đầu vào, hệ thống sẽ chọn một số expert phù hợp cùng với một expert chung (shared expert) để sinh ra phản hồi. Cách tiếp cận này giúp tiết kiệm đáng kể tài nguyên tính toán mà vẫn đảm bảo độ chính xác và chất lượng đầu ra.

Mô hình được huấn luyện từ hàng nghìn tỷ token văn bản và hàng tỷ hình ảnh, kết hợp cả dữ liệu công khai và dữ liệu tổng hợp từ mô hình AI trước đó. Meta cũng áp dụng nhiều biện pháp để kiểm soát chất lượng đầu ra như tinh chỉnh có giám sát, học tăng cường và tối ưu hóa theo sở thích người dùng, đảm bảo kết quả an toàn và phù hợp.

Ưu điểm và nhược điểm của LLaMA

LLaMA là một trong những mô hình ngôn ngữ tiên tiến, mang lại nhiều lợi thế trong xử lý ngôn ngữ tự nhiên. Tuy nhiên vẫn tồn tại một số hạn chế cần lưu ý khi ứng dụng.

Ưu điểm

- Hiểu ngôn ngữ sâu sắc: LLaMA có khả năng nắm bắt và xử lý các câu hỏi phức tạp, giúp cải thiện hiệu quả trong dịch vụ khách hàng, sáng tạo nội dung và nhiều lĩnh vực khác.

- Khả năng mở rộng cao: Mô hình có thể xử lý lượng dữ liệu lớn, phù hợp với các ứng dụng quy mô rộng từ tài chính đến y tế.

- Tự học và thích nghi: LLaMA liên tục học hỏi qua tương tác, ngày càng nâng cao độ chính xác và khả năng đáp ứng.

- Hỗ trợ đa ngôn ngữ: Mô hình có thể hiểu và xử lý nhiều ngôn ngữ khác nhau, giúp phá bỏ rào cản ngôn ngữ trong giao tiếp toàn cầu.

Nhược điểm

- Thiên vị dữ liệu và vấn đề đạo đức: LLaMA phụ thuộc vào chất lượng dữ liệu huấn luyện. Nếu dữ liệu có thiên lệch, kết quả đầu ra cũng có thể sai lệch, gây lo ngại về mặt đạo đức, đặc biệt trong các lĩnh vực nhạy cảm.

- Tốn kém tài nguyên: Khả năng mạnh mẽ đi kèm với yêu cầu lớn về tính toán, gây hạn chế về khả năng tiếp cận và chi phí vận hành.

- Thiếu khả năng nhận biết cảm xúc: Mặc dù xử lý ngôn ngữ tốt, LLaMA chưa thể hiểu và phản hồi chính xác theo cảm xúc con người.

Ứng dụng của mô hình LLaMA

Mô hình LLaMA được ứng dụng rộng rãi trong nhiều lĩnh vực khác nhau bao gồm:

Tạo nội dung văn bản

LLaMA có thể tự động sinh ra các đoạn văn giống như người viết, tiết kiệm thời gian cho việc viết bài, tạo mô tả sản phẩm hay kể chuyện sáng tạo. Ví dụ, đội ngũ marketing có thể dùng LLaMA để soạn thảo bài email tự động hoặc mô tả sản phẩm nhanh chóng và hiệu quả.

Trí tuệ nhân tạo đàm thoại

Chatbot và trợ lý ảo dựa trên LLaMA có thể giao tiếp tự nhiên, xử lý các câu hỏi phức tạp trong nhiều ngữ cảnh khác nhau. Chẳng hạn, một trang thương mại điện tử có thể tích hợp chatbot LLaMA để hỗ trợ khách hàng, trả lời thắc mắc và theo dõi đơn hàng.

Dịch máy đa ngôn ngữ

Nhờ được huấn luyện trên nhiều ngôn ngữ, LLaMA có thể nâng cao độ chính xác trong việc dịch thuật giữa các ngôn ngữ khác nhau. Các tổ chức quốc tế hiện nay thường tận dụng LLaMA để dịch báo cáo và thông tin liên lạc, thúc đẩy hợp tác hiệu quả hơn.

Phân tích cảm xúc

LLaMA có thể được tinh chỉnh để xác định cảm xúc ẩn trong văn bản, nhận biết được thái độ tích cực, tiêu cực hay trung tính. Một số doanh nghiệp đã tận dụng tính năng này để theo dõi và đánh giá phản hồi của khách hàng trên mạng xã hội.

Tóm tắt văn bản

Mô hình giúp rút gọn các tài liệu dài thành những bản tóm tắt ngắn gọn, dễ hiểu, hỗ trợ nhanh chóng tiếp cận thông tin trọng yếu. Các nền tảng tin tức có thể dùng LLaMA để tạo bản tóm tắt nhanh các sự kiện nóng hổi cho người đọc.

Điểm khác biệt của LLaMA so với các mô hình AI khác

LLaMA được đánh giá là một trong những mô hình ngôn ngữ tiên tiến, cạnh tranh với các “ông lớn” như GPT-3, PaLM, Chinchilla và Gopher trên nhiều tiêu chí.

- Mô hình LLaMA 65B thể hiện khả năng lý luận thường thức vượt trội, trong khi phiên bản 33B thường đứng đầu trên các bộ dữ liệu như ARC ở cả mức độ dễ và khó. Các mô hình như GPT-3, Chinchilla hay PaLM thường gặp nhiều hạn chế hơn khi xử lý các dạng bài tập lý luận này.

- Trong các bài kiểm tra trả lời câu hỏi đóng và kiến thức dạng trivia, LLaMA cho thấy hiệu suất cao hơn so với GPT-3, Gopher, Chinchilla và PaLM, đặc biệt là trên các bộ dữ liệu như Natural Questions và TriviaQA.

- Khi đánh giá khả năng đọc hiểu, LLaMA không chỉ vượt qua GPT-3 mà còn đạt kết quả gần tương đương với PaLM 540B, dù quy mô của LLaMA nhỏ hơn đáng kể.

- Đối với các tác vụ lý luận toán học, LLaMA hiện vẫn chưa vượt qua được Minerva, một mô hình được tinh chỉnh chuyên biệt để xử lý bài toán toán học.

- Trong lĩnh vực sinh mã lập trình, LLaMA cho thấy hiệu quả rõ rệt khi vượt qua LaMDA và PaLM trên các bộ dữ liệu kiểm tra như HumanEval và MBPP.

- Xét về kiến thức chuyên ngành, LLaMA có độ phủ kém hơn PaLM 540B do quy mô mô hình nhỏ hơn. Vì vậy, khả năng truy xuất thông tin chuyên sâu của LLaMA còn hạn chế.

- Về xử lý ngữ cảnh, LLaMA sở hữu các phiên bản như Maverick và Scout có thể xử lý lần lượt 1 triệu và 10 triệu token, giúp vượt xa các mô hình khác vốn bị giới hạn bởi cửa sổ ngữ cảnh nhỏ hơn nhiều.

- LLaMA được thiết kế dưới dạng mô hình mở, cho phép dễ dàng tiếp cận và tiết kiệm tài nguyên triển khai. Trong khi đó, nhiều mô hình nổi bật khác vẫn bị giới hạn bởi tính chất đóng và chi phí vận hành cao.

>>> Bạn có thể quan tâm: Deepseek là gì?

Tiềm năng của LLaMA trong tương lai

Trong năm 2024, LLaMA đã chứng kiến sự tăng trưởng vượt bậc khi trở thành mô hình ngôn ngữ mở được tải xuống nhiều nhất với hơn 650 triệu lượt tải. Theo đó, Meta liên tục cải tiến các phiên bản LLaMA, từ LLaMA 3 đến các phiên bản nhẹ, đa phương tiện, phù hợp với nhiều thiết bị từ di động đến doanh nghiệp. Nhờ hợp tác với nhiều đối tác công nghệ lớn như AWS, Microsoft Azure, Google Cloud hay NVIDIA, LLaMA được tối ưu hóa để vận hành hiệu quả trên đa dạng nền tảng.

Hơn thế nữa, LLaMA đang từng bước khẳng định vai trò quan trọng trong nhiều lĩnh vực:

- Trí tuệ nhân tạo đàm thoại và hỗ trợ khách hàng: Được tích hợp trong chatbot, tổng đài ảo và các trợ lý kỹ thuật số, nâng cao trải nghiệm người dùng và giảm tải cho đội ngũ chăm sóc khách hàng.

- Dịch vụ công và phân tích dữ liệu: Một số chính phủ như Ấn Độ và Argentina đã ứng dụng LLaMA để hiện đại hóa quy trình hành chính, tăng cường khả năng truy xuất và phân tích dữ liệu phục vụ công dân.

- Ngành công nghiệp sáng tạo và truyền thông: Các doanh nghiệp như Spotify, IBM cùng nhiều tập đoàn lớn đã sử dụng LLaMA để tối ưu hóa nội dung, phân tích hành vi người dùng và tự động hóa quy trình vận hành.

- Mạng xã hội và thiết bị thông minh: Meta AI tích hợp LLaMA trên các nền tảng như WhatsApp, Facebook, Messenger và cả kính thông minh Ray-Ban Meta giúp người dùng tương tác dễ dàng và liền mạch hơn trong cuộc sống hàng ngày.

Trong tương lai, Meta dự kiến sẽ tiếp tục nâng cấp mô hình LLaMA. Những cải tiến tập trung vào khả năng suy luận, giao tiếp bằng giọng nói và tạo nội dung video bằng AI. Ngoài ra, Meta cũng hướng đến phát triển các hệ thống AI tự chủ nhằm hỗ trợ người dùng và doanh nghiệp hiệu quả hơn. Mục tiêu dài hạn của LLaMA là trở thành nền tảng AI hàng đầu, thúc đẩy sáng tạo và kết nối con người qua công nghệ hiện đại trên phạm vi toàn cầu.

>>> Xem thêm: Stable Diffusion là gì?

Kết luận

LLaMA không đơn thuần là một mô hình AI mà là bước đột phá định hướng tương lai của trí tuệ nhân tạo mở. Với khả năng mở rộng linh hoạt, hỗ trợ đa ngôn ngữ, tích hợp sâu vào nhiều nền tảng và thiết bị, LLaMA đang mở ra một kỷ nguyên mới – nơi AI không còn là công nghệ xa vời mà trở thành một phần thiết yếu trong mọi hoạt động đời sống. Hy vọng với những chia sẻ của VNPT AI về xu hướng phát triển của LLaMA đã góp phần giúp các doanh nghiệp có thêm trải nghiệm AI thân thiện, đa dạng và cá nhân hóa hơn.

15/09/2025

15/09/2025